Mit dem Start von Teslas Robotaxi-Dienstes in Austin nehmen wieder einmal die Debatten um die verwendeten Sensoren an Fahrt auf. Die einen vertreten fest die Meinung, dass Teslas Ansatz mit Kameras alleine nicht ausreichen werden, und zitieren dazu jede Menge an Beispielen, wie Teslas Full Self Driving (FSD) Fehler begeht, die anderen meinen, dass Teslas Ansatz sehr wohl funktionieren muss, denn Menschen würden selbst auch „nur mit Augen“ fahren.

Was aber stimmt nun? Wer hat recht? Dazu will ich drei Aspekte betrachten. Zuerst die Hardwareausstattung von Waymo und Tesla. Zweitens, welche Vorteile und Herausforderungen es mit den jeweiligen Ansätzen gibt. Und drittens, wie Waymo und Tesla an die Entwicklung herangeht, denn auch diese unterscheiden sich massiv.

Worauf ich nicht eingehen werde sind die ML-Systeme und Simulationen, in die auch sehr viel Geld und Aufwand hineingesteckt werden muss, um aus den erfassten Daten Sinn zu machen und Millionen von Varianten durchspielen zu können.

1) Sensoransätze

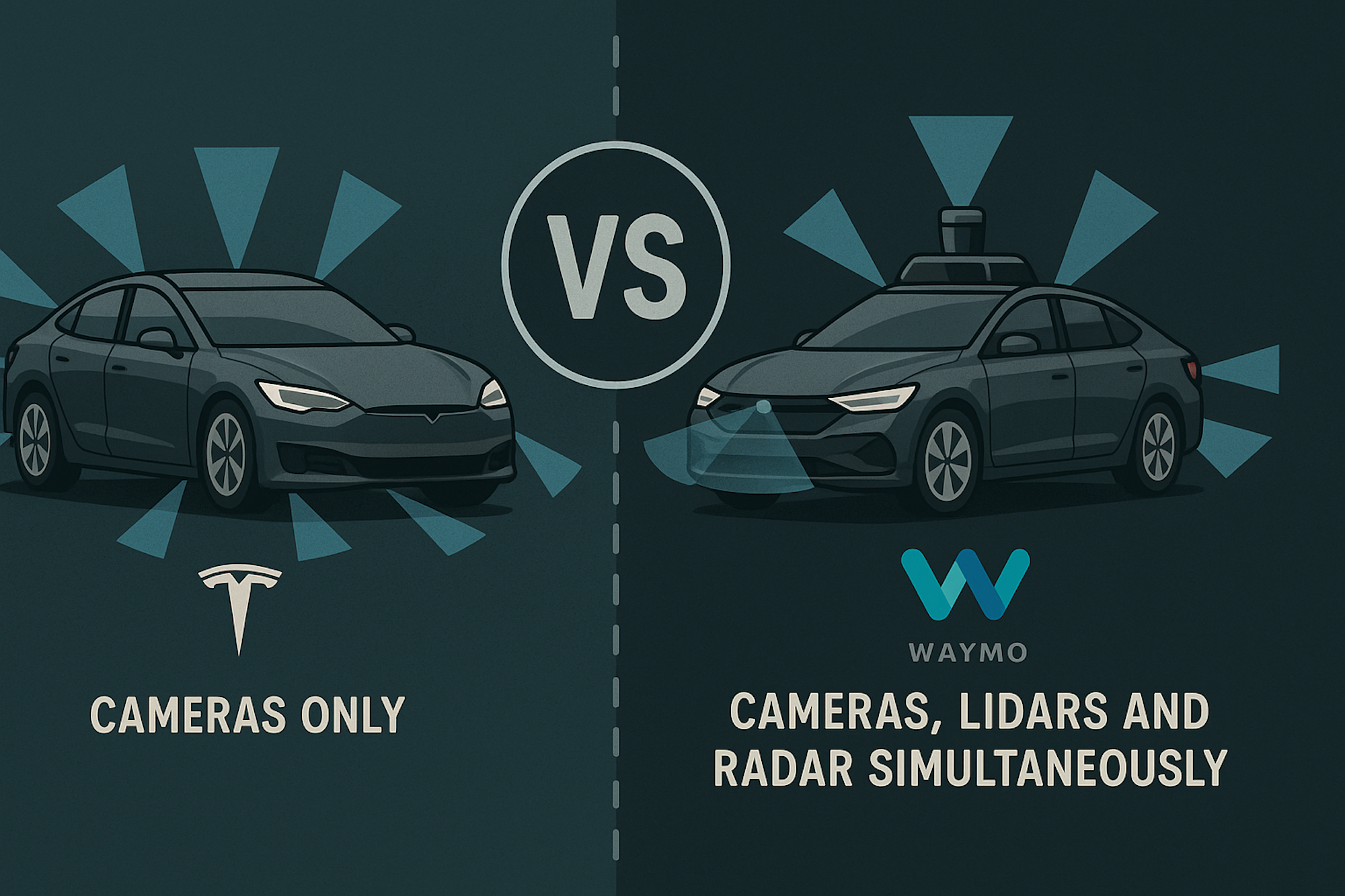

Es gibt, grob gesagt, zwei dominante Ansätze:

Sensoransatz Waymo

Waymo und die meisten anderen Entwickler von Selbstfahrtechnologiesystemen verwenden eine Kombination von mehreren Sensormodalitäten. Zumeist umfassen sie mehrere Kameras, Lidars und Radars. In manchen Fällen (wie Zoox) sogar Thermalkameras.

Die Kameras selbst können sich dabei um welche mit unterschiedlichen Auflösungen oder um solche mit Weitwinkelobjektiv handeln.

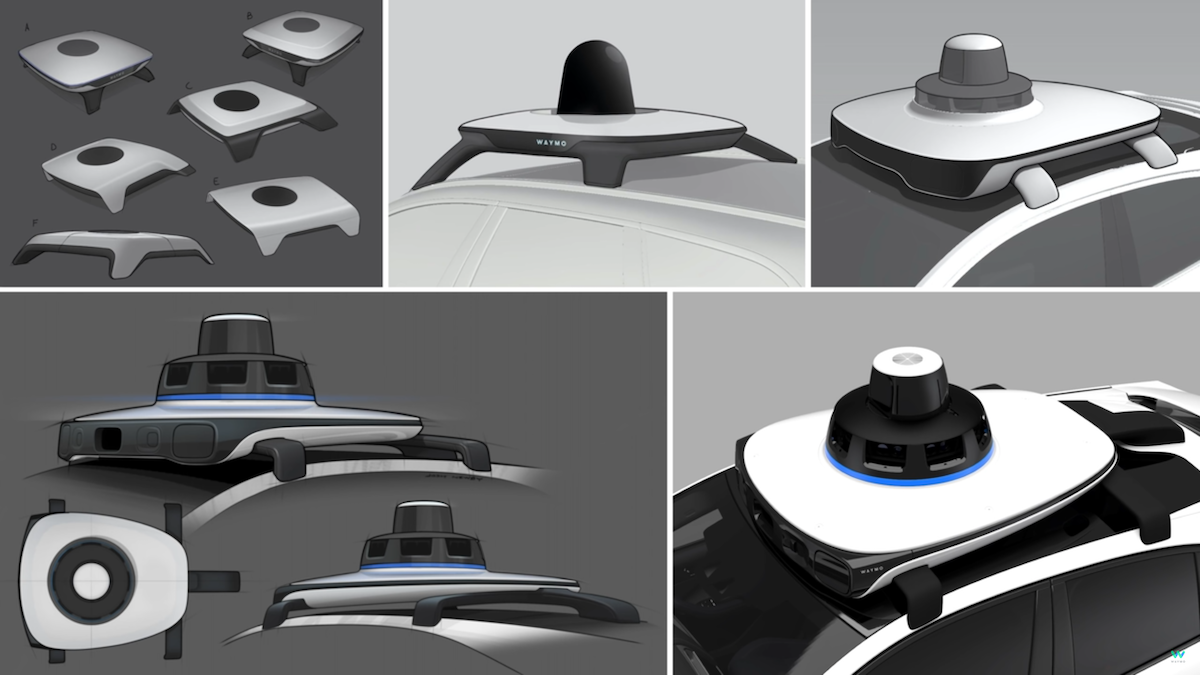

Bei den Lidars wiederum können sie weiter (wie beispielsweise bei Waymo dasjenige auf dem Dach mit einer Reichweite von 500 Metern, ein Long Range Lidar) und kürzere wie das Laser Bear Honeycomb Lidar), die zwischen 95 und 360 Grad der Umgebung abbilden können.

Auch bei Radar gibt es Variationen, von traditionellen 3D Radars zu den neuen 4D Radar, die zu den 3 Raumdimensionen noch die Geschwindigkeit und Richtung eines Objektes miterfassen.

Die Sensoren selbst benötigen für den Einsatz unter jeden Witterungsbedingungen zusätzliche Einbauten, wie Scheibenwischer oder Heizungen oder Kühlvorrichtungen, damit sie innerhalb eines Temperaturbereichs auch zuverlässig und genau messen können.

Alle Sensoren gemeinsam erfassen 360 Grad um das Fahrzeug herum, wie im folgenden Bild exemplarisch dargestellt.

Die gelieferten Daten werden dann von leistungsstarken Prozessoren verarbeitet, die auch das Fahrzeug steuern. Diese Systeme, wie auch Bremsen oder Lenkung, müssen redundant ausgelegt werden, um bei einem Ausfall immer noch ein Backupsystem zu haben und das Fahrzeug sicher zu steuern und zum Anhalten bringen zu können.

Hat der Waymo Driver – so Waymos Name für seine Selbstfahrtechnologiepaket – in der fünften Generation (wie sie auf den aktuellen Jaguar iPace zu sehen sind) noch 29 Kameras, 5 Lidare und 6 Radare, so sind es bei der sechsten Generation nur mehr 13 Kameras, 4 Lidare und 6 Radare. Das reduziert die Kosten und den Wartungsaufwand. Doch diese Sensoraufbauten sind noch recht sperrig und machen das Auto für Autoliebhaber unansehnlich.

Aktuell wird davon ausgegangen, dass ein Fahrzeug wie der Jaguar iPace mit den Sensoren an Board nach wie vor um die $200.000 pro Stück kostet. Recht teuer für ein Robotaxi, unerschwinglich für ein Privatfahrzeug. Doch wie immer bei Elektronik fallen die Preise rapide. Kostete ein Lidar noch vor wenigen Jahren (wie im folgenden Video) noch locker $75.000 pro Stück, so liegen die Preise heute bei weit unter einem Zehntel dieses Preises.

Sensoransatz Tesla

Tesla und wenige andere Hersteller (wie ursprünglich AutoX) verfolgen einen Cameras-only (oder Cameras-first wie AutoX) Ansatz. Beim Cameras-only-Ansatz kommen ausschließlich Kameras zu Einsatz, die die Umgebung in einer 360-Grad-Ansicht erfassen. Im Fall von Tesla sind das 8 Kameras: 3 vorne, 1 jeweils links und rechts hinter dem Vorderreifen nach hinten sehend, 1 jeweils auf dem B-Träger nach vorne sehend, und eine Backup-Kamera mit Weitwinkelsicht. Eine weitere, neunte Kamera befindet sich im Wageninneren hinter dem Rückspiegel, die den Fahrer und Innenraum überwacht.

Zwar hatte Tesla bis etwa 2020 Radare in die Fahrzeug eingebaut, wurden sie bis vor kurzem nicht mehr eingebaut. Angeblich sind nun wieder welche verbaut, sollen aber nach Angaben von Tesla nicht für das autonome Fahren eingesetzt werden. Tesla Sensoren sind nahtlos in das Auto eingebaut und damit fast nicht sichtbar. Sie beeinflussen jedenfalls die Form des fahrzeugs nur wenig, im Gegensatz zum Waymo.

In Teslas eingebaut sind weiters zwei leistungsstarke, aus Tesla-eigener Fertigung stammende GPUs, die die Daten prozessieren und das Fahrzeug steuern.

Aktuell wird davon ausgegangen, dass die Kosten für Teslas Hardware-Kit einen niedrigen vierstelligen Dollarbetrag ausmacht.

2) Vorteile und Herausforderungen

Jeder dieser Ansätze hat Vorteile, steht aber auch vor Herausforderungen.

Ansatz Waymo

Waymos Ansatz erfordert zuerst mal einiges an Investitionen in Hardware. Fahrzeuge müsen gekauft, diese mit den Sensoren ausgerüstet, und danach auf die Straßen gebracht werden. Nun müssen viele, am besten Millionen von Kilometern mit Sicherheitsfahrern in unterschiedlichen Geographien und unter verschiedenen Verkehrs- und Wetterbedingungen gefahren werden.

Dabei werden mit all den Sensoren pro Stunde Terabytes an Daten erzeugt, die man speichern, vom Fahrzeug runterladen und speichern, und dann in den ML-Systeme und im Simulator verarbeiten muss.

Diese Daten sind je nach Sensor sehr präzise. Sie können auf Millimeter die Position von Randsteinen oder Fahrbahnmarkierungen erfassen. Aus diesen erstellt Waymo dann hochpräzise Navigationskarten, die sich stark von denen für Menschen gedachte Navigationskarten unterscheiden. Mit GPS, anderen digitalen Karten, Texterkennung an Gebäuden oder Schildern und sogar die Erkennung von typischen, lokalen Orientierungspunkten (McDonalds-Schild, Uhrturm…) kann ein Fahrzeug exakt seine Position bestimmen, auch wenn mal ein Faktor (wie GPS-Signal in Städten mit Hochhäusern) nur unpräzise oder gar keine Informationen liefert.

Die Erstellung dieser hochpräzisen Navigationskarten müssen vor dem Betriebsstart eines Robotaxidienstes mittels sogenannter „Mapping Runs“ (Kartenerfassungsfahrten) durchgeführt werden. Dabei werden die Robotaxis mit Sicherheitsfahrern auf die Straße geschickt und fahren über mehrere Wochen hindurch alle Straßen ab um Daten zu erfassen. Diese Daten werden dann zu Navigationskarten zusammengefügt und auf alle Fahrzeuge hochgeladen.

Bei diesen Millionen Kilometern, die Fahrzeuge auf diese Weise abspulen, werden auch viele Randszenarien erfasst. Das sind nicht so häufig vorkommende Situationen, denen die Fahrzeuge erst nach und nach begegnen. Ich bezeichne sie auch als die „Kurze Nase„. Eines dieser berühmten Beispiele ist das von der älteren Frau im elektrischen Rollstuhl, die mitten auf der Straße herumfuhr und mit einem Besenstiel versuchte eine Ente zu verscheuchen.

Hier sind noch dutzende weitere Beispiele von solchen Randszenarien, die den Fahrzeugen erst mit zig Millionen von Kilometern an Fahrten im realen Verkehr unterkommen, und vom autonomen Auto sicher behandelt werden müssen.

Dank der unterschiedlichen Sensordaten erhält das Fahrzeug ein präziseres Bild von der Umgebung und den Verkehrsteilnehmern. Jeder Sensortyp verhält sich dabei anders. Kann eine Kamera nicht durch den Nebel oder einen Sandsturm sehen, so trifft das auf Radar oder Lidar nicht zu. Die werden davon nicht beeinträchtigt. Umgekehrt liefern diese beiden weniger Pixel als Kameras, die eine höhere Auflösung haben können. Und Kameras liefern Farbinformation.

Mehr Sensormodalitäten (Kameras UND Lidar UND Radar) heißt aber nicht, dass alles damit automatisch sicherer wird. Zuerst mal besteht die reale Gefahr, dass damit mehr Fehler eingebaut, weil die Software komplexer wird. Im Zusammenspiel mit all diesen Sensormodalitäten stellt sich dann immer die Frage, welcher Sensor wohl recht hat, wenn die Sensortypen unterschiedliches melden. Kamera sagt ja, Lidar sagt nein. Wer hat recht? Danke der exponentiell steigenden Kombinatorik werden nie alle Fälle durchgetestet werden können.

Der Waymo-Ansatz ist somit ein langsamer, teurer und aufwendiger, der sich Region nach Region vornimmt. Dafür ist er aber – sofern alles gut geht – sicherer und kurzfristig der vermutlich beste Ansatz. Um skalieren zu können ist aber trotz immer besser werdenden Werkzeugen und Erfahrung viel Geld und Aufwand notwendig.

Ansatz Tesla

Tesla musste eine Entscheidung treffen, die anders war als bei Waymo. Das Unternehmen entschied sich, das Tesla Hardwarekit in Form von 8 Kameras und zwei GPUs in alle Fahrzeuge einzubauen und an Kunden mitauszuliefern. Dank Over-the-air-Updates (OTA) kann Tesla nicht nur Software und Daten auf die Kundenfahrzeuge hochladen, sondern auch telemetrische und sonstige Fahrdaten (Video) von den Kundenfahrzeugen herunterladen. Von den aktuell über 8 Millionen verkauften und mit dem Hardwarekit ausgestatteten Fahrzeugen in Kundenhänden hat Tesla somit Zugriff auf Milliarden von Kilometern an Daten. Und das sind nicht nur Videodaten, sondern eben auch telemetrische Daten.

Und hier kommen wir zu einem wichtigen Punkt: der Mensch fährt nicht nur mit den Augen (= Kamera), er fährt mit dem ganzen Körper und erhält somit weitere Informationen. Geräusche, Vibrationen, Beschleunigungen. Moderne Autos erfassen all solche Daten heute auch, wie eben Querbeschleunigungen zum Auslösen von Airbags etc. Teslas Ansatz umfasst somit mehr als nur Kameradaten.

Erst mit ausreichend verkauften Fahrzeugen mit dem Hardwarekit hat Tesla über die Zeit mehr und mehr Daten von den Kundenfahrzeugen erhalten. Ab einem Tipping Point erhält Tesla aber Unmengen an Fahrdaten. Diese Daten sind allerdings, zugegebenermaßen, von geringerer Qualität als jene, über die Waymo verfügt. Die Auflösung und Bildraten der Videos sind geringer, telemetrische Daten füllen nicht immer diese Lücke.

Was Tesla hier an Datenqualität eingebüßt hat, muss durch Algorithmen wettgemacht werden. Denn wo man beispielsweise die Größe eines Objekts (z.B. LKW) dank Lidar gut erfassen kann, ergeben sich aufgrund kleiner Pixelfehler mit den Kameras falsche Größen, wie Scale.AI gezeigt hat.

Doch zeigt sich aus der Vergangenheit, dass Algorithmen immer besser werden und letztendlich alle Nachteile überkommen können. Wir sahen das beispielsweise bei den Algorithmen der Videokompression. Durch Datenleitungen mit gleichbleibenden Übertragungsraten können wir dank cleverer Komprimierungsalgorithmen mehr Videodaten durchschicken, als je zuvor.

Womit Tesla heute zu kämpfen scheint, und wie es sich in Austin gerade zeigt, sind Blendungen der Kameras durch Gegenlicht (Sonne, Gegenverkehr). Doch auch das ist algorithmisch lösbar., indem mit Anpassungen an Kameraeinstellungen gearbeitet wird. Auch Regen sollte lösbar sein. einerseits durch den angepassten Einsatz der Scheibenwischer, andererseits hat Tesla dazu ein eigenes ML-System namens DeepRain.

Tesla, im Gegensatz zu Waymo, erstellt selbst keine hochpräzisen Navigationskarten im Vorfeld, sondern während des Fahrens in jedem auto individuell. Die Annahme hier ist, dass die Umgebung sich zu rasch ändert, durch Baustellen, Absperrungen, Jahreszeitlichen Bedingungen wie Laub das im Herbst plötzlich auf den Straßen liegt und Fahrbahnmarkierungen verdeckt. Allerdings erfordert eine solche Herangehensweise einiges an zuverlässiger Rechenpower, und damit kämpft Tesla noch.

Ich möchte nochmals auf die Wette hinweisen, die Tesla hier eingegangen ist, und wie sie sich von Vorgehensweisen traditioneller Hersteller unterscheiden. Tesla traf vor Jahren die Entscheidung, ein mehrere tausend Dollar teures Hardwarekit in alle Fahrzeuge einzubauen, für das die Software für den eigentlichen Zweck – autonomes Fahren – noch gar nicht fertig ist. Und man nicht auch weiß, wann sie fertig sein wird und diese Funktion von den Kunden verwendet werden kann. Man überrede mal die Managementebenen bei traditionellen Herstellern, diese Vorgehensweise zu wählen, und man wird aus der Tür gelacht oder ist seinen Job gleich los.

Schon heute können wir im Nebel fahren, wenn menschliche Fahrer hinter dem Steuer sitzen. Auch wenn wir dann nicht so weit sehen, wird in den meisten Fällen eines gemacht: es wird die Geschwindigkeit angepasst. Man fährt vorsichtiger. Warum also sollte diese für Menschen passende Methode nicht für den Tesla-Ansatz auch funktionieren?

3) Entwicklungsansatz

Als dritten Punkt will ich einen hochbringen, der in der ganzen Debatte gar nicht wahrgenommen wird. Es handelt sich um die geografische Reichweite der beiden Ansätze.

Waymo: Den Topf zum Kochen bringen

Waymo nimmt sich eine Stadt und eine Region nach der anderen vor, um seinen Robotaxidienst anzubieten. Diese Gebiete sind klar regional klar abgegrenzt (geofenced) und werden nach und nach erweitert.

Aktuell hat Waymo alles unter Kontrolle, denn entweder als Waymo (SF, Bay Area, LA, Austin, Phönix) oder unter dem Label eines Partners wie Uber (Atlanta) wird die Robotaxiflotte betrieben.

Waymo bringt somit Wasser in einzelnen Töpfen zum Kochen.

Tesla: Den Ozean zum Kochen bringen

Tesla sammelt nicht nur Daten von Kundenfahrzeugen, die in klar limitierten Regionen unterwegs sind, sondern egal wo sie unterwegs sind. Also heute zumeist in ganz Nordamerika, Europa, Asien, Australien. Tesla muss somit versuchen gleichzeitig alle Unterschiede zu berücksichtigen, wie sie in allen erfassten Ländern gegeben sind. Das ist eine viel komplexere Aufgabe. Stadt, Land, Links- und Rechtsverkehr, weit auseinanderliegende, inklusive extreme Wetterbedingungen, oder Verhaltensweisen von Menschen in unterschiedlichen Kulturen. Eine Herkulesaufgabe, wie man sich vorstellen kann.

Deshalb erscheint der Fortschritt bei Teslas Ansatz so langsam. Doch der stete Tropfen höhlt den Stein, und irgendwann wird ein Status erreicht werden, wo mit einem Schalterumlegen alle weltweit fahrenden Teslas überall autonome fahren werden können.

Tesla versucht den ganzen Ozean auf einmal zum Kochen zu bringen.

TLDR

Wenn wir Faktoren wie die folgenden berücksichtigen

- Preis von Lidar (und allen zusätzlichen Sensoren wie Wärme-/Infrarotkameras);

- immer bessere Algorithmen für Kameras.

und mehr Sensormodalitäten, was bedeutet

- mehr Software-Code, der die Komplexität des Software-Stacks erhöht;

- mehr Komplexität bedeutet auch, dass mehr Softwarefehler auftreten;

- Umgang mit widersprüchlichen Signalen (Kamera sagt ja, Lidar sagt nein – wem soll man trauen?) – man braucht Software-Routinen, um die entsprechenden Entscheidungen zu treffen (was wiederum mehr Software-Fehler mit sich bringt);

- höhere Kosten für die Wartung (Kalibrierung, Reinigung, Fehleranalyse…);

- unterschiedliches Verhalten bei verschiedenen Temperaturen, Lichtverhältnissen und Geschwindigkeiten;

- erhöhter Leistungsbedarf des Fahrzeugs;

- erhöhter Datenfluss, der Verarbeitungs- und Speicherkapazitäten erfordert.

sehen wir schnell, dass die Aussage, dass mehrere Sensormodalitäten automatisch die bessere Wahl sind, nicht mehr so eindeutig ist.

Zusammenfassung

All das vorher genannte führt uns zu folgender Zusammenfassung:

- Beide Ansätze werden erfolgreich sein;

- Der Waymo-Ansatz ist heute viel teurer als Teslas Ansatz. Erstere sind nur für Robotaxiflotten leistbar, letztere für alle Autos (Privat-PKWs);

- Kurzfristig ist der Waymo-Ansatz sicherer und ist eine geofenced Region rascher in Betrieb zu nehmen. Mittel- und langfristig wird der Tesla-Ansatz dank immer fortschreitenden Algorithmen auch sicher genug sein;

- Waymo zielt auf Robotaxiflotten, Tesla sowohl auf Privat-PKW, als auch auf Robotaxiflotten;

Wer mehr Marktanteile einheimsen kann, hängt vor allem davon ab, wer das Wettrennen um folgende Fragestellung gewinnt: Wird ein Waymo-Sensorstack rascher billiger und damit in vielen Fahrzeugen einsatzbereit, oder werden beim Tesla-Ansatz die Algorithmen rascher besser und sicherer?

Noch etwas

Kyle Vogt, Gründer und ehemaliger CEO von Cruise Automation, spricht über diese Unterschiede:

Dieser Beitrag ist auch auf Englisch erschienen.

1 Kommentar